En el siguiente post se detalla la configuración de un cluster de Proxmox compuesto por 2 nodos, ambos configurados con un pool ZFS, y con una tarea de replicación de las maquinas entre ambos nodos 🙂

La configuración que aquí se describe es una configuración básica e inicial, en esta config no se define la alta disponibilidad y volúmenes compartidos (CEPH), aunque en posteriores entradas lo incluiré.

El esquema de configuración seria el siguiente:

Nodo 1

Interfaz administración (MGMT): 10.70.10.0/24

Interfaz vms (WORKLOAD): 10.90.100.0/24

Interfaz replicación (SYNC): 10.96.96.0/24

Nodo 2:

Interfaz administración (MGMT): 10.70.10.0/24

Interfaz vms (WORKLOAD): 10.90.100.0/24

Interfaz replicación (SYNC): 10.96.96.0/24

** Un poco de rollo 🙂 , evidentemente el entorno sobre el que se monta son (los host físicos son maquinas virtuales), y la red va a 1Gb, lo recomendable en este caso seria disponer de mínimo bocas a 10Gbit para la parte de Lan y de 25Gbit en el caso de la replicación, y ya no hablamos si estaríamos trabajando con CEPH.

Primeros pasos en la configuración:

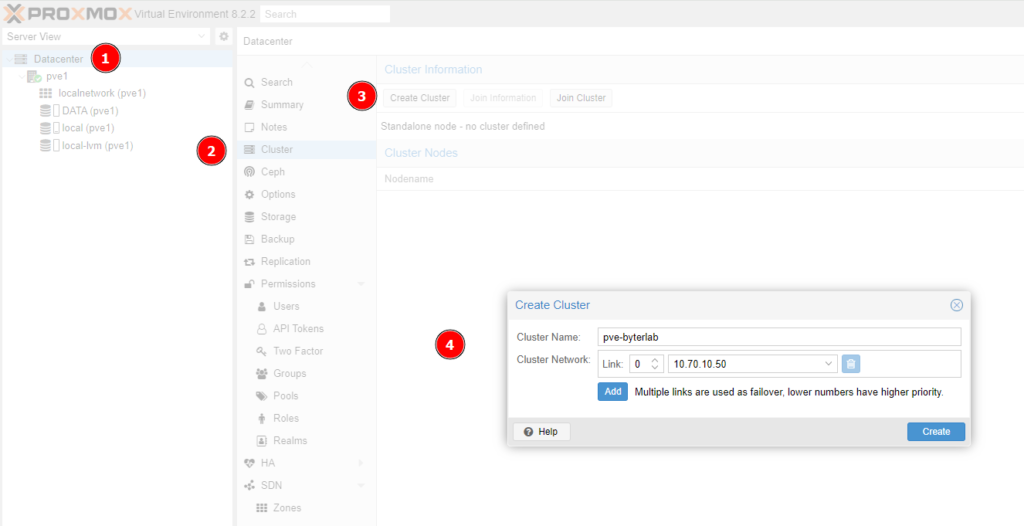

1· Creacion del cluster

**Para añadir un host a un cluster, el host que vayamos a añadir NO debe tener alojada ninguna VM.**

***A tener en cuenta ciertas cosas en esta primera config, se nos da la opción de definir mas interfaces para tener un failover… (lo suyo en un entorno real seria estar trabajando con LACP) bien… aquí comentar algo… En Proxmox no existe como en Vmware la posibilidad de definir que interfaz se utiliza para segun que uso «VMKERNELS» (almacenamiento, backup, etc..), solo encontraremos una excepción para la parte de replicación/migración donde si nos permite definir una interfaz, no obstante en este y otros docs iré indicando las posibles configuraciones y la forma de definirse.. (Para estas configs, abstenerse los que les mola el tema de ruteos.. jajaja)***

Ejemplo de una config en entorno real:

VMs: 2x 10Gb with balance-alb (1x Switch1 1x Switch2)

iSCSI Storage: 2x 10Gb with balance-alb (1x Switch1 1x Switch2)

Ceph Network: 4x 10Gb with balance-alb (2x Switch1 2x Switch2)

Red de administracion/corosync: 4x 1Gb with balance-alb (2x Switch1 2x Switch2)

Red de Migracion/Replicacion: 2x 10Gb with balance-alb (1x Switch1 1x Switch2)

Después de todo esto, empezamos con la config…

Nos iremos a la opcion «Create Cluster»

En la ventana nos pedira darle un nombre y la direccion ip del cluster.

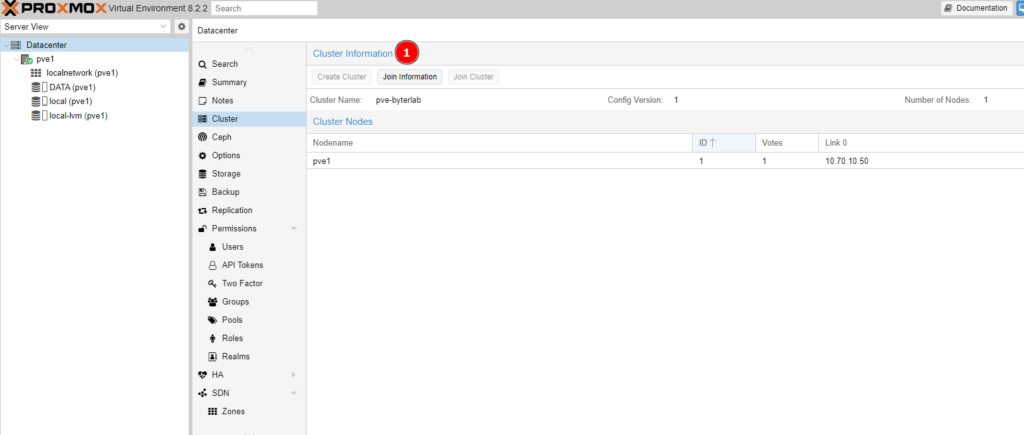

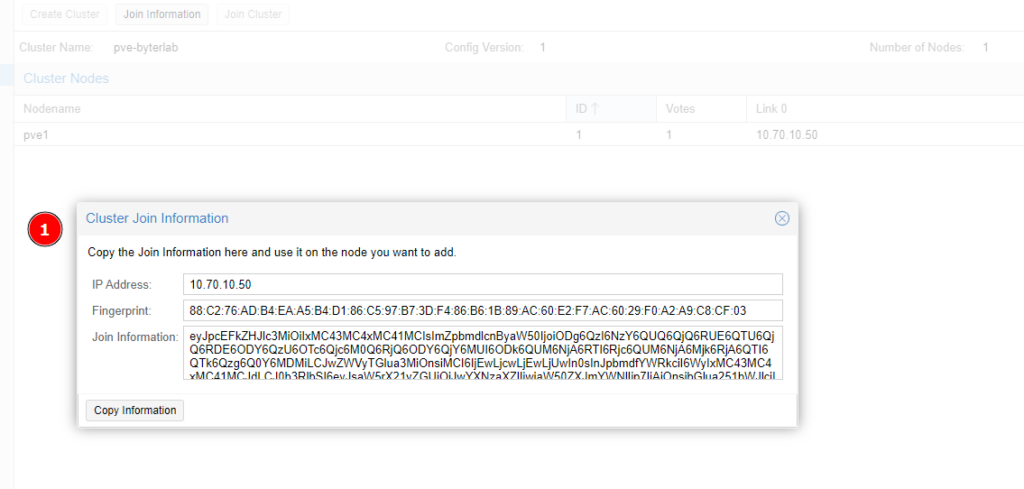

Una vez creado hacemos click en «Join Information» para recuperar la info que necesitamos para agregar el otro host al cluster.

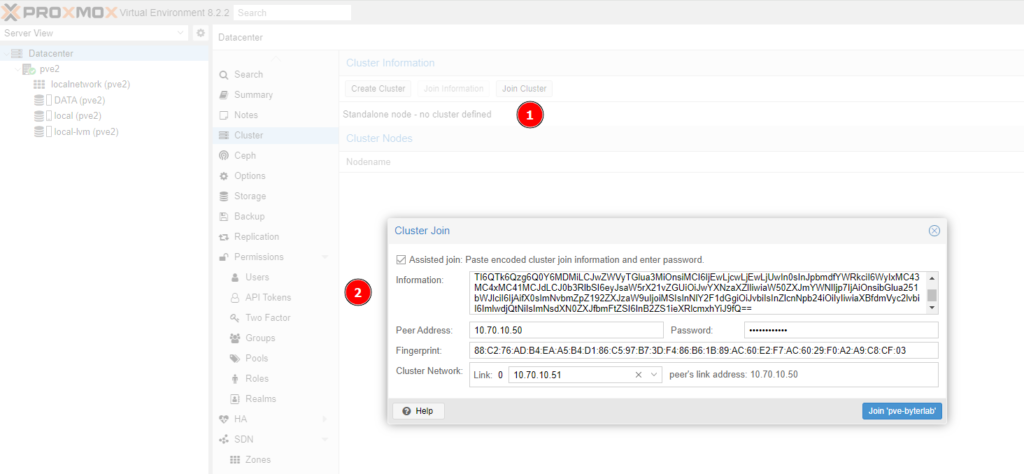

Con esta info nos iremos al segundo Host para agregarle al Cluster

**En estas ultimas versiones, «no se si sera un bug», aun después de agregarle me ha pasado que a veces se queda pillado el asistente después de agregarle, pero vamos que actualizamos la pagina abierta en el navegador y para adelante..

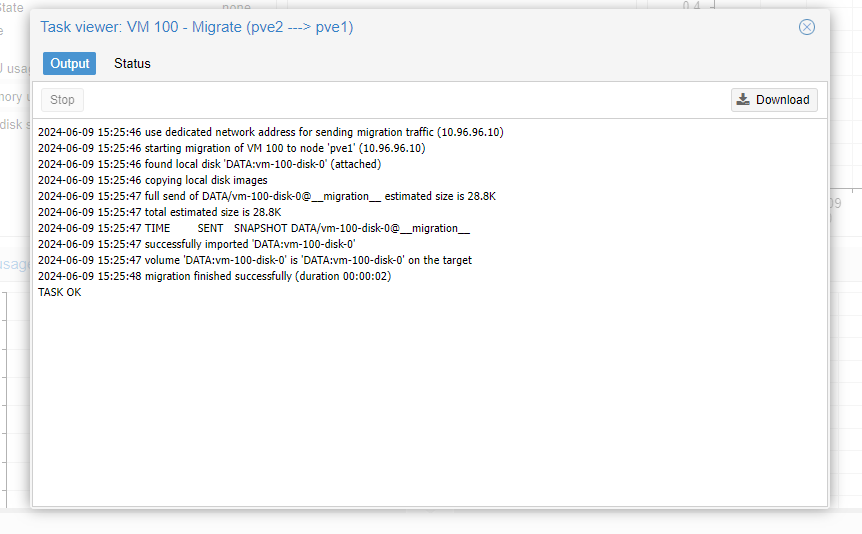

2. Realizar prueba de migracion

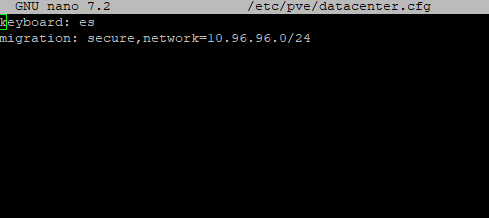

Antes de nada definiremos que interfaz va a ser la encarga de este tipo de trafico, para ello aqui no quedan mas ******* que abrirnos una shell y editar el siguiente fichero /etc/pve/datacenter.cfg

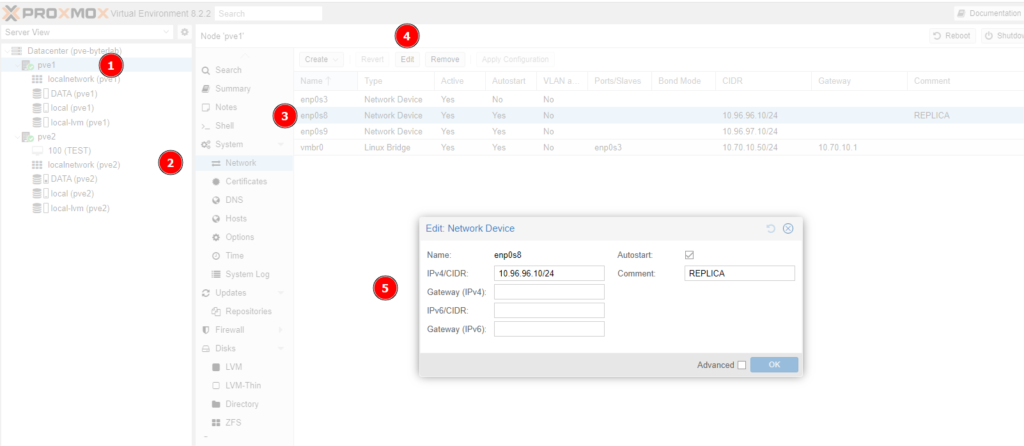

En mi caso la interfaz ya la tengo definida, para configurar las interfaces seria en este apartado:

Definimos la config en uno de los nodos: (Esta config se replica de forma automática entre todos los nodos del cluster)

Hacemos una prueba, y vemos que va por la interfaz de la red 10.96.96.0/24

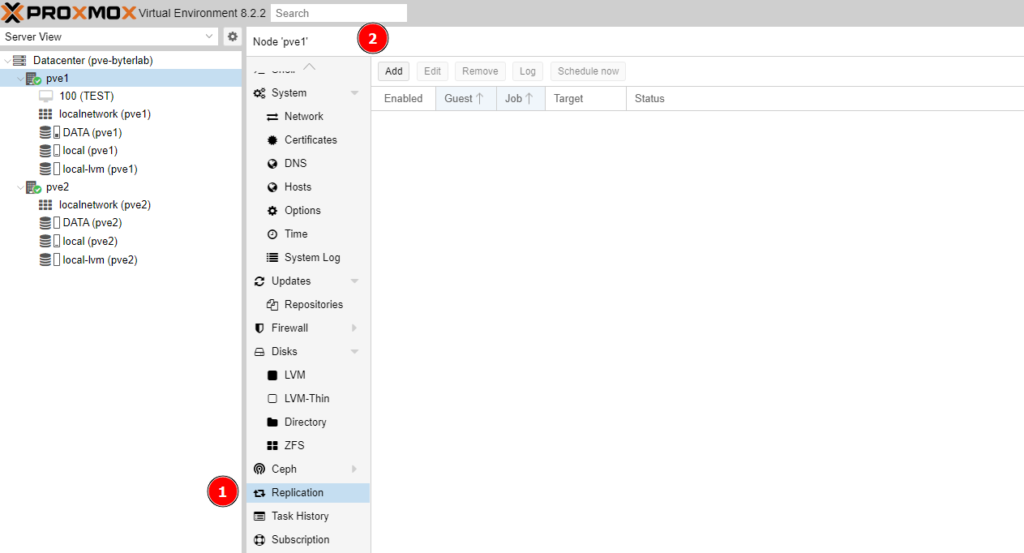

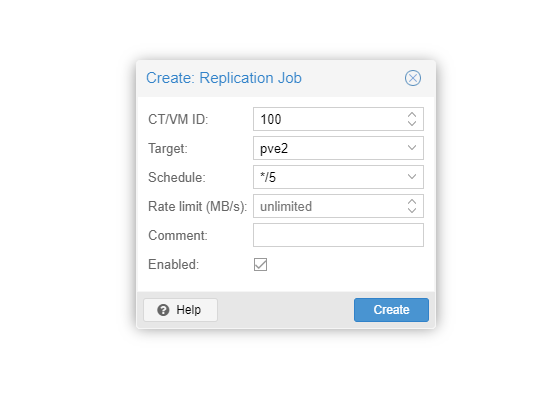

3. Definir tareas de replicación de maquinas virtuales